本文综述了模型压缩最新的技术进展,包括量化、剪枝和知识蒸馏等主流方法,以及混合精度量化、动态剪枝等新兴技术。文章分析了模型压缩的必要性和挑战,探讨了其在不同应用场景中的应用案例,并展望了其未来发展趋势和潜在风险,例如模型压缩在移动端部署和边缘计算中的应用,以及如何提高模型的安全性、可靠性和可解释性。

模型压缩的必要性与挑战

近年来,深度学习模型在各个领域取得了显著的成果,但其庞大的模型规模和高昂的计算成本也成为了制约其应用的关键因素。尤其是在移动设备、嵌入式系统等资源受限的场景下,部署大型深度学习模型变得非常困难。因此,模型压缩技术应运而生,旨在降低模型的存储空间、计算复杂度和能耗,从而提升模型的效率和可部署性。

模型压缩技术的挑战在于如何在降低模型大小的同时,尽可能保持模型的精度。这需要在模型的冗余信息去除和关键信息保留之间取得平衡。此外,不同模型压缩方法的适用范围和效果差异较大,需要根据具体的应用场景和模型结构进行选择。一些研究表明,部分压缩方法可能会导致模型泛化能力下降,从而影响模型在实际应用中的性能。

主流模型压缩方法:量化、剪枝和知识蒸馏

目前,主流的模型压缩方法主要包括量化、剪枝和知识蒸馏。量化是指将模型参数的精度降低,例如将32位浮点数转换为8位整数,从而减少模型的存储空间和计算量。剪枝是指去除模型中不重要的连接或神经元,以简化模型结构。知识蒸馏是指利用一个大型模型(教师模型)的知识来训练一个小型模型(学生模型),使学生模型能够学习到教师模型的知识,并达到与教师模型相近的性能。

例如,量化技术在图像识别领域得到广泛应用,可以有效降低模型大小和计算量,同时保持较高的识别精度。剪枝技术则常用于自然语言处理领域,通过去除不重要的连接可以有效降低模型的复杂度,提高运行效率。知识蒸馏技术则常用于模型迁移学习,可以将大型模型的知识迁移到小型模型中,提升小型模型的性能。

模型压缩技术的最新进展与应用案例

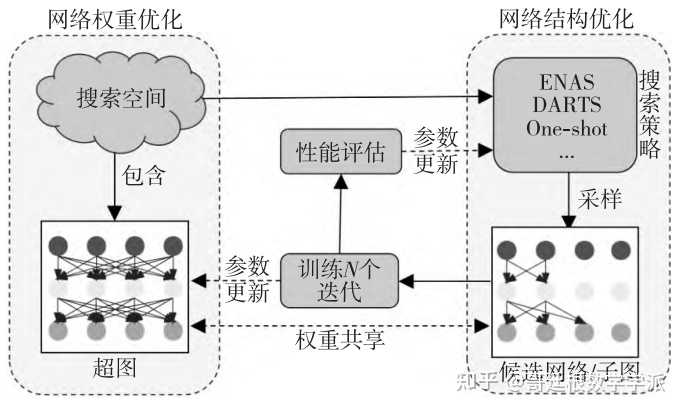

近年来,模型压缩技术取得了显著的进展,涌现出一系列新的方法和技术,例如混合精度量化、动态剪枝、以及基于神经架构搜索的模型压缩方法。这些新方法在降低模型大小和计算量方面取得了更好的效果,同时更好地平衡了模型精度和效率。

例如,混合精度量化技术可以根据模型参数的重要性选择不同的量化精度,从而在精度和效率之间取得更好的平衡。动态剪枝技术则可以根据输入数据的不同动态调整模型的结构,以适应不同的场景和任务。基于神经架构搜索的模型压缩方法则可以自动搜索出具有较好性能和效率的模型结构,无需人工干预。这些技术在一些实际应用中得到了验证,例如,在智能手机上部署高精度图像识别模型,以及在嵌入式设备上进行实时语音识别等。

模型压缩技术的未来发展趋势及潜在风险

模型压缩技术的未来发展趋势主要包括:开发更高效的压缩算法,探索更广泛的应用场景,以及解决模型压缩技术面临的挑战。

未来的研究方向可能集中在如何更好地平衡模型的精度和效率,以及如何解决模型压缩技术在不同应用场景下的适应性问题。同时,模型压缩也面临一些潜在的风险和挑战,例如压缩后的模型可能更容易受到对抗样本的攻击,以及模型压缩可能导致模型的解释性降低。需要加强对这些问题的研究,以确保模型压缩技术的安全性、可靠性和可解释性。

模型压缩技术的社会经济效益

- 降低硬件成本:模型压缩使部署深度学习模型所需的硬件资源减少,从而降低了硬件成本。

- 提高能源效率:压缩后的模型能耗降低,有助于提高能源效率,减少碳排放。

- 扩展应用场景:模型压缩使深度学习模型能够部署在更多资源受限的设备上,拓展了其应用场景。

- 促进技术创新:模型压缩技术的持续发展,推动了深度学习领域的技术创新,进一步提升了人工智能技术的应用能力。

- 提升用户体验:更小更快更省电的模型,带来更好的用户体验。

鄂ICP备15020274号-1

鄂ICP备15020274号-1